戦場のAI、希望と脅威の狭間で人類の選択を問う

技術革新の波が押し寄せる中、AIは私たちの生活や社会のあり方を大きく変えようとしている。

自動運転車から軍事用意思決定支援システム、さらにはAI搭載の無人兵器まで、その応用範囲は広範に及ぶ。

しかし、急速な発展の陰で、明確な規制やガイドラインの不在が浮き彫りになっている。

特に注目すべきは、人間が関与しないAI兵器の出現だ。

これは倫理的・人道的観点から深刻な懸念を呼び起こしている。

各国で異なる規制アプローチ、国境を越えるAI技術の拡散、そして予測困難な影響。 私たちは、この複雑な現実にどう向き合うべきなのか。

京都産業大学の岩本誠吾客員教授が、AIの利用と規制に関する倫理と国際法の最前線を語る。

技術の恩恵と潜在的リスク、希望と課題が交錯する中、私たちはこの急速に変化する社会にどう適応していくべきなのか。

AIと人類の未来を左右する重要な議論の幕が、今まさに上がる。

AIにおける民生、軍事、兵器の3つの階層、開発と倫理の狭間で議論される世界。

────まずは、研究領域について教えてください。

国際法の中には、武力紛争時に適用される法律の分野があり、かつては戦時国際法と呼ばれ、現在は国際人道法として知られています。私はこの分野、特に兵器規制について研究しています。

研究対象は主に通常兵器です。核兵器、化学兵器、生物兵器などの大量破壊兵器ではなく、対人地雷やクラスター爆弾、そして近年注目を集めている無人兵器(ドローンなど)です。

これらのドローンは陸、海、空、水中で使用され、最近ではAI技術を搭載し始めています。

私の研究の中心は、AI搭載ドローンや軍事目的でのAI利用が、国際法上どのように規制されているかを明らかにすることです。

国際人道法では、不必要な苦痛を与える兵器や無差別的な被害をもたらす性質の兵器の使用を禁止しています。

兵器規制は、様々な国際人道法条約や軍縮条約によって具体化されています。

例えば、特定通常兵器条約や軍縮条約の対人地雷禁止条約やクラスター爆弾禁止条約があり、これらの条約に加盟している国々は、これらの兵器の使用が禁止されているんです。

しかし、非人道的で使用が禁止される兵器と、使用が許可される兵器の区別が曖昧な場合があります。この境界線を明確にすることが、私の研究の主要な目的です。

▲国会中継の様子「国会中継 参議院 外交・安全保障に関する調査会(2024/02/07)」で参考人として意見陳述────昨今のAI搭載兵器に関する国際法の規制は、どのように進んでいるのでしょうか?

2010年以降、人工知能(AI)は第3次ブームを迎え、急速に発展しています。

実際にAIは、今や身近な存在となり、お掃除ロボットや自動運転車など、様々な形で日常でも実用化されています。AIが身近になる中で、AIの利用は民生利用、軍事利用、そして、兵器利用3つの階層に分かれて議論されているんです。

AIは軍民両用が可能ですが、10年以内には兵器利用における技術が急速に進化すると考えられているんです。またAIが標的の選定、追尾、攻撃を人間の関与なしに実行できるAI兵器が誕生しつつあります。

AIの国際法の規制はすべて、人間中心主義の原則が重要視されています。つまり、人間が上位に位置し、機械はあくまでも補助的な役割を果たすという主従の関係性を維持することが求められているんです。

────人間中心主義の原則とのことですが、民生、軍事、兵器ではどのような基準が設けられているのでしょうか?

まず、1つめ目の民生用AIの規制に関して説明します。結論からお伝えすると民生用AIの規制は、世界各国の対応にはばらつきがあるのが現状です。ヨーロッパではAI規制法が今年制定され、リスクに応じて一定の基準が設けられました。

一方、日本ではまだ法制化には至っておらず、ガイドラインや原則の策定段階にあります。

日本政府は来年か再来年には法制化を目指していますが、世界的に見ると、多くの国が既に国内法でAIを規制しています。

しかし、各国が独自に法制化を進めることで、国際的な基準の不一致という問題が生じているんです。

人権や倫理的配慮を重視する日本やアメリカと、そうした制約を不要と考える国々との間で、AI活用に関する考え方に大きな隔たりがあります。

この差異は、AIの悪用や乱用のリスクを高める可能性があるでしょう。

例えば、サイバー空間の規制においても、各国の対応には大きな違いが見られます。中国のような国では政治的な理由でアカウントを削除するなど、厳しい規制が行われていますが、日本ではそのような極端な措置は稀です。

このような状況下で、人類とAIが共存するための共通基準の確立が急務となっています。

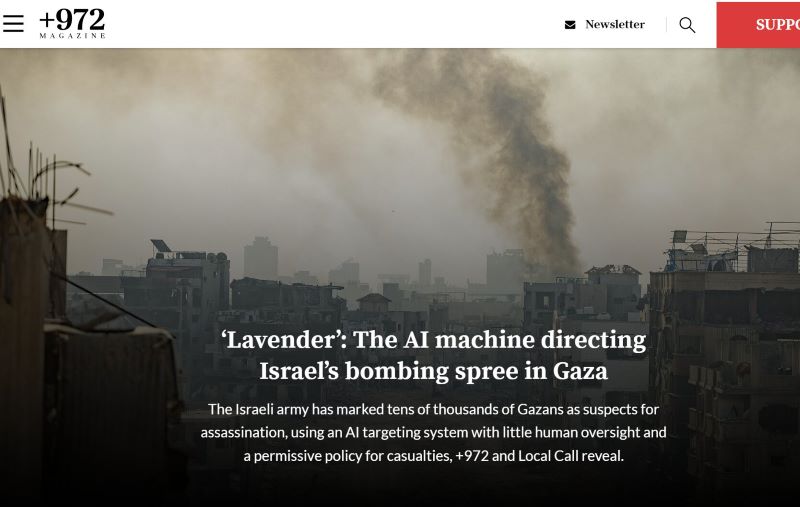

次に、2つ目の軍事用AIに関しては、現在、イスラエル・ガザ戦争やロシア・ウクライナ戦争で使用されている軍事システム(イスラエル使用のラベンダーやゴスペル、ウクライナ使用のゴッサムシステムなど)は、AIを活用した標的選定システムです。

▲画像引用:Yahoo!ニュース「イスラエルの独立系メディア+972マガジンのサイトで公開された「ラベンダー(Lavender):ガザでイスラエル軍に爆撃を指示する AI(人工頭脳)マシン」の調査報道」しかし、これらのシステムの精度は入力データの正確さに大きく依存しています。特に、イスラエル使用のシステムのように、不正確なデータは誤った結果を導き、民間人の犠牲につながる可能性があります。

AIの機械学習や深層学習においては、学習データのバイアスが結果にも反映されるという問題があるんです。これは、AIが必ずしも正しい判断を下すわけではないことを示しており、人間のような包括的で バランスの取れた判断をAIが行えるかどうかには疑問が残ります。

最後に兵器利用については、完全な「自律型致死兵器システム(LAWS)」の開発が進んでいます。これは、機械が自律的に標的を選定、追尾、攻撃する能力を持つ兵器システムです。

最近では、人間だけでなく物体も対象とする「自律兵器システム(AWS)」という概念にシフトしつつあります。

当初は20年先と言われていましたが、技術の急速な進歩により、今では10年以内、あるいは7年以内に自律兵器システムが実現する可能性も指摘されています。

▲自律兵器システム(AWS)の解説動画現状では、イスラエルのラベンダー・システムなどは、まだ完全な自律性を持っていません。機械が情報を収集し、指揮官に提示し、指揮官が最終決定を下すという、人間の管理下(ヒューマンコントロール)にある段階です。しかし、技術の進歩により、完全自律型システムに近づいています。

人間の場合、戦争による死傷者を目の当たりにすることで罪悪感が生まれ、戦闘を制限したり停止したりする心理的な制約が働きます。

しかし、機械にはこのような感情的な制約がないため、より徹底的な破壊や殺傷行為を行う可能性があるでしょう。

また、民間人の巻き添え被害などの複雑な状況判断や価値判断を、機械が適切に行えるかどうかは大きな課題です。

このような状況を受けて、国際社会では民生用、軍事利用、兵器利用のAIをそれぞれ適切に規制しようという動きが出ています。

────なるほど…これまでのお話を聞いていると、AIの利便性が強調されている昨今ですが、映画『ターミネーター』のスカイネットのような、人に害をなすAIの危険性を強く感じました…。AIの利用は、倫理観がより問われていくような…。

従来、科学者や技術者は新しい技術の開発に専念し、倫理的な問題にはあまり関心を示さないことが多かったんです。

しかし最近では、コンピューター工学者や人工知能研究者の間でも倫理規範の重要性が認識されるようになってきました。

民間企業も、AIを使用する際の倫理規範を策定するなど、責任ある技術開発と利用に向けた取り組みを始めているんです。

例えば、ソニーやAmazonなどの大手企業が、AI利用に関する企業理念や倫理指針を公表しています。

AI技術の軍事利用は、効率性と精度の向上をもたらす一方で、倫理的な問題や予期せぬリスクを含んでいるのです。これらの課題に対処するため、国際的な規制や倫理基準の確立が急務となっています。

ブレーキの効かない列車のように、加速するAI技術開発競争

────現在の軍事利用に関するAI研究は、どこまで発展しているのでしょうか?現在の人工知能(AI)技術、特に兵器利用に関する状況は複雑な様相を呈しています。

現在実用化されているのは、特定の狭い分野で優れた性能を発揮する「ナロー(狭い)AI」です。これは将棋、チェス、囲碁などのゲームで人間を上回る能力を示しており、軍事分野では近接防空システム(CIWS)のような特化型AIが既に実用化されています。

これらのシステムは、飛来する弾を自動的に検知し、迎撃する能力を持っています。

▲近接防空システム(CIWS)のファランクス Block1A・近接防御火器システム(CIWS) 強襲揚陸艦ペリリューの様子しかし、AI技術の進化は留まることを知らず、次の段階として「AGI(Artificial General Intelligence、汎用人工知能)」の開発が進められているんです。

AGIは人間と同等かそれ以上の知能を持ち、様々な分野で柔軟に対応できる能力を持つと予想されています。

さらに驚くべきことに、数年以内にAGIの実現可能性があると言われているんです。

AGIの先には、さらに高度な「スーパー・インテリジェンス(超知能)」の出現が予想されています。

このレベルのAIは人間の知能を遥かに超え、自己保存のために人間を欺いたり、支配したりする可能性ありとの懸念が一部の研究者から示されています。

この概念はSF映画「ターミネーター」のようなシナリオを連想させ、最近ではコンピューター科学者たちの間でも真剣に議論されているんです。

────これまでのお話を聞いていると、AIの利用の脅威性を強く感じますね…SF映画で見ていたロボットVS人類が実現するというか…

おっしゃる通りです。これらのAI技術の急速な進歩は「技術的特異点(テクノロジカル・シンギュラリティ)」と呼ばれ、AIが人間の知能を追い越す分岐点として注目されています。

特に懸念されているのは、これらの高度なAI技術が兵器に転用される可能性です。

そのため、国際社会はAI技術の発展を適切に管理し、潜在的なリスクを軽減するための対策を早急に講じる必要性に直面しています。

AIは多くの利点を持つ一方で、重大な危険性も秘めています。この技術の発展は、人間とロボットの関係に関する従来の概念を根本から覆す可能性があります。

1940年代頃から、ロボットは人間のサポート役として捉えられてきました。この「人間中心主義」あるいは「ヒューマン・セントリック・アプローチ」は、AI技術の開発においても重要視されています。

人間の尊厳を守り、AIが人間を完全に代替することを防ぐため、様々な規制や検証方法が検討されているんです。

しかし、AIの軍事利用をめぐる国際競争は激化しています。特にアメリカ、中国、ロシアの3カ国が先頭を走っており、これらの国々はAI技術の支配が世界の覇権につながると考えています。

例えば、プーチン大統領はAIを制する者は世界を制すると明言しているんです。これらの国々は、自国がAI開発で先行することで安全を確保しようとする一方、他国に遅れをとることへの恐れから、開発競争から降りることができない状況に陥っています。

AI技術は経済、政治、軍事など全ての分野の基盤となるため、その重要性は計り知れません。

特にアメリカは、中国やロシアがAI開発で先行することを懸念しています。民主主義や人権を重視するアメリカは、これらの価値観への配慮から開発のペースが遅れることを危惧しているんです。

一方、中国やロシアは人権や人道性への配慮が比較的少ないため、より積極的に開発を進めているという見方もあります。

さらに、国際情勢の緊張も高まっており、例えば、ロシアと北朝鮮の軍事協力関係は、日本を含む周辺国に新たな脅威をもたらす可能性があります。

このような状況下で、国際社会はAI技術の規制や管理について議論を重ねていますが、技術開発の速度に追いつくのは極めて困難な状況です。

まるでブレーキの効かない列車のように、AI技術開発競争は加速を続けており、これをいかに制御し、平和的に利用していくかが国際社会の大きな課題となっています。

────AIを軍事利用する際の最も大きな課題を教えてください。

AIの活用は、その使用場面によって適切性が大きく変わります。

金融取引やがんの早期発見、サイバー攻撃対策、フェイクニュース検出など、迅速な判断や大量のデータ処理が必要な分野では、AIの利用が非常に有効です。

例えば、株取引においては、AIの0.01秒単位の高速判断が人間の能力を遥かに超えています。

しかし、軍事利用においては、AIは「第三の軍事革命」と呼ばれるほど大きな影響力を持ち、その展開の予測が非常に困難であり、その危険性が高いとされています。

火薬や核兵器の発明に匹敵する革命的な変化をもたらす可能性があるのです。

AIを戦争に使用すると、被害が甚大になる可能性が高く、人間の感情や倫理観に基づく判断が欠如することで、より過酷な結果をもたらす恐れがあります。

AIの大きな課題の一つは、その判断プロセスの不透明性、いわゆる「ブラックボックス問題」です。

通常の機械の場合、故障時に分解して問題箇所を特定できますが、AIの場合、なぜそのような判断に至ったのかを説明することが難しい場合があります。

そのため、「説明可能な透明性のあるAI」の開発が重要視されています。これにより、AIの判断プロセスを後から検証し、エラーの原因を特定することが可能になるのです。

例えば、AIが誤った判断をした場合、それが入力データの問題なのか、処理過程の問題なのかを明確にする必要があります。

これは、AIシステムの改善や信頼性の向上に不可欠です。自動車の故障と同様に、問題箇所を特定し修正することで、AIを継続して使用し改善していくことができます。

また、AIはサイバー攻撃に対して脆弱性があり、乗っ取られて改ざんされるリスクがあるのです。このため、AIシステムの安全性と信頼性の確保が重要な課題となっています。特に、軍事用や重要インフラ用のAIシステムでは、この点が極めて重要です。

▲国会中継の様子「国会中継 参議院 外交・安全保障に関する調査会(2024/02/07)」で参考人として意見陳述AIの適切な利用には、自動車産業に類似した安全基準の確立が必要です。

これは、AI開発者(メーカー)側の製造基準と、AI利用者(ユーザー)側のリテラシー(適切な使用方法の理解)の両方を含みます。開発者は安全で信頼性の高いAIを作る責任があり、利用者はAIの適切な使用方法や注意事項を理解する必要があるでしょう。

例えば、開発者側は、AIシステムの設計段階で、後からの検証や説明が可能な構造を組み込む必要があります。また、サイバーセキュリティ対策を十分に施し、システムの堅牢性を確保する必要があるのです。

一方、利用者側は、AIシステムの特性や限界を理解し、適切に使用する能力(AIリテラシー)を身につける必要があるでしょう。これには、AIの判断を盲信せず、必要に応じて人間が介入する判断力も含まれます。

さらに、AIの発展に伴い、AIが生成するフェイクニュースとそれを検出するAIの対立など、新たな課題も生まれています。これは、AI技術の進化が社会にもたらす複雑な影響を示しているでしょう。

このように、AIの利用にはメリットとリスクの両面があり、使用場面に応じた適切な判断と、安全性・信頼性の確保、そして開発者と利用者双方の責任ある行動が求められています。AIの発展と共に、これらの課題に対する取り組みも進化し続けることが重要です。

人間主導の未来を築け!AI時代の舵取り

▲国会中継の様子「国会中継 参議院 外交・安全保障に関する調査会(2024/02/07)」で参考人として意見陳述────AI技術の発展がもたらす未来について、先生の考察を教えてください。

AI技術の発展は止められない勢いで進んでおり、今後さらに加速していくと考えられます。

これに伴い、人間のAIへの依存度も高まっていきますが、同時にAIを人間のように錯覚してしまう危険性も指摘されています。

例えば、高齢者が会話するロボットを家族のように扱ったり、ペットを家族同然に考えたりするように、AIも人間と同一視されやすい存在になりつつあるでしょう。

AIの発展には明確な両面性があり、そのメリットを最大限に活かしつつ、リスクやデメリットをいかに抑制するかが重要な課題となっています。

AIが機械であることを常に念頭に置き、故障や誤作動、サイバー攻撃の可能性があることを認識しておく必要があるでしょう。

国際社会におけるAIの影響は特に顕著です。

────なるほど…その中でも懸念されるポイントなどはありますか?

最も懸念されるのは、フェイクニュースの蔓延とハイブリッド戦(情報戦と物理的戦争の組み合わせ)の増加です。

例えば、アメリカの大統領選挙における外国勢力の干渉や、台湾と中国、ロシアとウクライナの間で行われている情報戦などが挙げられます。

AIによって、より精巧なフェイクニュースや偽の画像・動画が作成されるようになり、国際関係が疑心暗鬼に陥る危険性が高まっているのです。

これに対処するため、AIを使ってフェイクニュースを検出する試みや、画像や情報に認証マークを付けるなど、真偽を判断するためのシステム構築が進められています。

しかし、多様なメディアが存在する現代社会では、何が正しい情報なのかを判断することが非常に難しくなっています。一度拡散された誤った情報は、後から訂正されても誤った認識が定着してしまうことが少なくありません。

フェイク技術の進化は目覚ましく、以前は粗雑だったフェイク画像や動画が、現在では非常に精巧になっています。政治家の偽の画像や動画が作成され、拡散されるケースも増えているんです。

これらは国際社会や政治に大きな影響を与える可能性があります。

AIの利用には責任が伴うでしょう。AIを使用する際は、最終的に人間が説明責任を持つ必要があり(アカウンタビリティ)、常に人間の関与(ヒューマン・コントロール)が求められます。また、AIのブラックボックス化を避け、誤作動の原因を追究できるようにすることも重要です。

戦争の分野でも、AIの影響は無視できません。戦争がますます非人間化し、ボタン一つで人命を左右するようなゲーム感覚の状況が生まれています。

AIの使用により、武力行使の敷居が下がり、常時戦争状態という新常態(ニューノーマル)になる危険性も指摘されています。言い換えれば平時と戦時の境界が曖昧になり、情報戦や低強度の軍事行動が日常化する中で、AIが効果的に活用される可能性も高まっているのです。

科学技術の進歩は、生活を便利にし活動の範囲を世界に広げてきました。例えば、Windows 95の登場でパーソナルコンピューターが普及し、その後スマートフォンやiPhoneの登場で情報のやり取りが容易になりました。

Zoomのようなツールも、私たちの生活を大きく変えています。しかし、この急速な進歩は影の部分も持っているのです。

技術の進歩のスピードは加速しており、10年、20年かかっていた変化が今では1年、2年で起こるようになっています。そのため、5年後、10年後の世界を予測することが非常に困難です。

この急速な技術進歩に伴い、プライバシーとセキュリティの課題も深刻化しています。個人情報の漏洩やサイバー攻撃のリスクが高まっており、便利なサービスほど、使い方によっては危険性を伴う可能性があります。最近の角川書店へのサイバー攻撃事件は、その一例と言えるでしょう。

結論として、AI技術の発展は避けられませんが、その利点を活かしつつ、リスクを最小限に抑える努力が必要です。

社会全体で技術の影響を注視し、適切な対策を講じていくことが、これからの時代には不可欠となるでしょう。技術の進歩に対して必要以上に悲観的になる必要はありませんが、将来への不安や課題に対して真摯に向き合い、解決策を模索していく必要があります。

人間主役のAI時代:人間力で制する未来の鍵

▲国会中継の様子「国会中継 参議院 外交・安全保障に関する調査会(2024/02/07)」で参考人として意見陳述────最後に読者の皆様にメッセージをお願いします!

科学技術の進歩は人類にとって本質的に良いものだと想います。

しかし、その発展には光と影の両面があり、リスクや危険性も伴います。そのため、科学技術と人間がいかに共存共生していくかを考えることが重要です。

技術を無批判に受け入れるのではなく、適切な受け入れ方や心構えを持つことが、真の共存共生には不可欠です。

現代社会において、私たちは科学技術と切り離して生きることはできません。そのため、最適な共存の形を模索する必要があります。その際に重要なのは、常に人間を中心に考え、人間の尊厳を大切にすることです。

機械に使われるのではなく、機械を使いこなす主体であり続けることが重要になります。これは、チャーリー・チャップリンの映画「モダン・タイムス」が比喩的に描いたように、人間が機械に使役されるような状況を避けるということです。

AIとの関係においても同様で、AIに使われるのではなく、人間が主体性を保ちながらAIを活用することが大切でしょう。ある程度AIに依存することは避けられないとしても、全面的な依存は避けるべきです。

例えば、学生がレポート作成を完全にAIに頼ってしまうような事態は問題です。このような行為が自己の成長を阻害するということを理解し、AIとの適切な付き合い方を各自が考える必要があります。

AIやコンピューターとの関わりが深まるほど、逆説的に自己を見つめ直す機会が増えるとも言えます。

「自分はどうあるべきか」「自分は何をすべきか」といった本質的な問いに立ち返ることが求められるでしょう。機械に頼れば頼るほど、自我や自己実現の意味を問い直さざるを得なくなるのです。

これは決して容易なことではありませんが、一人一人がAIとの付き合い方を考え直すことは、自分自身を見つめ直す貴重な機会となります。

この過程は、AIとの関係に限らず、人生全般において重要な自己省察の機会となるでしょう。

結局のところ、科学技術と共存しながら、いかに人間らしさや個性を失わずに生きていくかが、これからの時代の大きな課題となります。

技術の進歩を享受しつつ、常に自分自身を見つめ直し、人間性を磨いていくことが、これからの社会で求められる姿勢なのです。

はい

50%

いいえ

50%

はい

50%

いいえ

50%